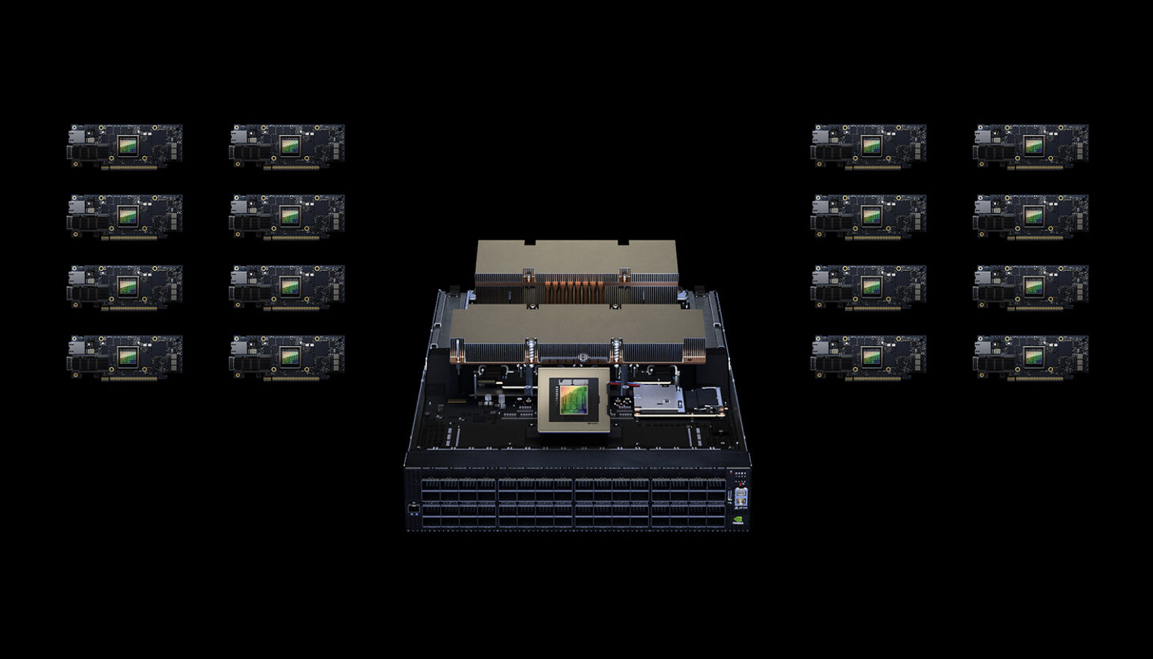

ChatGPT는 인공지능(AI) 기술의 혁신적인 모델로, OpenAI에서 개발되었습니다. Microsoft Azure CTO인 마크 루신노비치가 NVIDIA와 Microsoft Azure가 협력하여 개발한 특별 제작 AI 슈퍼컴퓨터 인프라와 기술 스택에 대해 설명합니다. 이 인프라는 ChatGPT와 같은 대형 언어 모델(Large Language Models, LLMs)을 어떠한 규모에서도 호스팅하고 지원하는 데 필요한 기술과 인프라를 제공합니다.

NVIDIA와 Microsoft Azure가 협력 개발

- 데이터 병렬 처리 방식을 통한 성능 향상

- 확장 가능한 가상 머신(Virtual Machine)과 네트워킹

- 서버 고장 대응 및 체크포인팅

- Low-rank adaptive (LoRA) 세부 튜닝

- 산업 선두주자의 활용 사례

- 기밀 컴퓨팅과 보안

1. 데이터 병렬 처리 방식을 통한 성능 향상

ChatGPT의 추론 작업 성능을 향상시키기 위해 NVIDIA H100 Tensor Core GPU를 사용하여 데이터 병렬 처리 방식을 도입했습니다. 이로 인해 추론 작업에서 약 30배의 성능 향상이 이루어졌으며, 모델 훈련에서는 약 4배의 성능 향상이 있었습니다.

2. 확장 가능한 가상 머신(Virtual Machine)과 네트워킹

LLMs의 높은 처리 요구를 충족하기 위해 NVIDIA Quantum-2 InfiniBand 네트워킹과 함께 가상 머신(VM)을 확장했습니다. 이를 통해 LLM 작업을 효율적으로 분산 처리하고, 더 큰 규모의 작업을 처리할 수 있게 되었습니다.

3. 서버 고장 대응 및 체크포인팅

대규모 훈련 작업에서는 서버 고장과 네트워크 문제가 불가피합니다. 이를 대비하기 위해 Microsoft의 프로젝트 포지(Project Forge)는 투명한 체크포인팅을 도입하여 작업을 중단하지 않고 신속히 재개할 수 있도록 지원합니다. 이를 통해 전 세계적으로 높은 이용률을 유지하면서 작업 효율성을 향상시킵니다.

4. Low-rank adaptive (LoRA) 세부 튜닝

억단위 파라미터를 처리하는 대규모 모델에서는 GPU 사용량과 체크포인트 크기를 최적화하는 것이 중요합니다. 이를 위해 Low-rank adaptive (LoRA) 세부 튜닝 방법이 도입되었습니다. 이 방법은 GPU 사용량을 감소시키고 체크포인트의 크기를 줄여줌으로써 대규모 모델의 처리를 더욱 효율적으로 관리할 수 있습니다.

5. 산업 선두주자의 활용 사례

Wayve와 같은 산업 선두주자들은 AI 슈퍼컴퓨터 인프라를 활용하여 계산 집약적인 작업을 수행하고 있습니다. 이러한 기술과 인프라의 혜택을 통해 다양한 산업 분야에서 AI를 적용하여 혁신적인 결과를 얻을 수 있습니다.

6. 기밀 컴퓨팅과 보안

Azure에서는 NVIDIA H100 GPU를 사용한 기밀 컴퓨팅 지원이 예정되어 있습니다. 이를 통해 민감한 데이터를 보호하고 가치 있는 AI 모델을 안전하게 사용할 수 있게 됩니다. 이는 AI에 대한 다중 파티 협업 사용 사례를 가능하게 하여 보안적인 면에서의 협업을 촉진합니다.

결론

OpenAI의 ChatGPT를 지원하기 위해 개발된 NVIDIA와 Microsoft Azure의 AI 슈퍼컴퓨터 인프라와 기술 스택은 대규모 언어 모델을 효율적으로 운영하고 처리 요구를 충족하기 위한 강력한 도구입니다. 데이터 병렬 처리, 가상 머신의 확장성, 체크포인팅 및 최적화 기술 등을 통해 AI 모델의 성능을 향상시키고 보안적인 면에서의 협업을 지원합니다. 이러한 기술과 인프라는 다양한 산업 분야에서 AI의 혁신적인 활용을 가능하게 하며, 미래에는 더욱 발전된 기능과 보안성을 제공할 것으로 기대됩니다.

'OpenAI' 카테고리의 다른 글

| ChatGPT와 RPA의 협업 강력한 업무 자동화를 위한 융합 기술 (0) | 2023.06.14 |

|---|---|

| ChatGPT 대화형 인공지능의 혁신 (0) | 2023.06.13 |

| 어도비 익스프레스(Adobe Express) 생성형 AI (0) | 2023.06.13 |

| Meta AI의 새로운 AI 모델 Segment Anything Model (SAM) (0) | 2023.06.13 |

| Meta AI ImageBind 6가지 모달리티를 통합한 AI 모델의 미래 (0) | 2023.06.10 |